Ratgeber

Billigkameras als Geschenk: acht Geräte im Test

von David Lee

Bei Videos wenden die Hersteller Tricks an, um die hohen Datenmengen zu verringern. Darunter leidet die Qualität. Eine höhere Bitrate zu wählen, nützt oft nichts, denn das Problem beginnt schon beim Auslesen des Sensors.

Schon mehrmals haben Hersteller Kritik einstecken müssen, weil ihre Kameras 4K nur mit einem beschränkten Bildausschnitt aufzeichnen können. Das ist natürlich unpraktisch – und der «4K-Crop» dementsprechend unbeliebt. Trotzdem kommen heute noch Kameras mit 4K-Crop auf den Markt. Da kein Hersteller seine Kunden gerne ärgert, stellt sich die Frage nach dem Warum.

Der 4K-Crop ist Teil eines umfassenderen Problems. Nämlich, dass eine Kamera die Auflösung von mindestens 20 Megapixeln auf eine viel kleinere Auflösung bringen muss. Und dass keine Methode dafür perfekt ist.

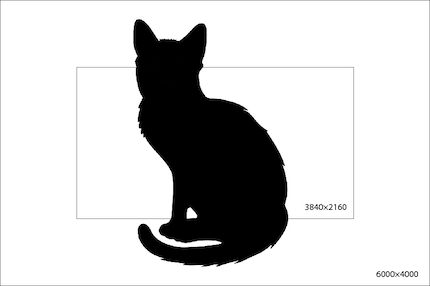

Nimmst du mit einer Fotokamera ein Video auf, entspricht die Auflösung des Sensors nicht der Video-Auflösung. Der Sensor der Sony Alpha 6400 beispielsweise hat 6000×4000 Pixel, also 24 Megapixel. Für Videos in UHD braucht es 3840×2160 oder in Full HD gar nur 1920×1080 Pixel. Das sind nur ungefähr 8 respektive 2 Megapixel.

Die naheliegende Lösung: Die Kamera nimmt das Originalbild und rechnet die Auflösung herunter – wie in Photoshop. Tatsächlich machen das einige Kameras so. Das nennt sich Oversampling, weil die Kameras dabei mehr Daten abgreift als sie fürs Endresultat benötigt.

Viele Kameras wenden jedoch Oversampling gar nicht oder nur teilweise an. Das Problem ist, dass die Kamera mindestens 24 Bilder pro Sekunde umrechnen muss – in Echtzeit. Besser 50 oder 60 Bilder pro Sekunde. Bei 60 Bildern sind das 3600 Bilder pro Minute, die die Kamera neu berechnen muss. Bei einem 20-minütigen Video ergibt das 72 000 Bilder.

Das erfordert eine ziemlich intensive Rechnerei. Heutige Prozessoren können das zwar, aber sie kommen dabei ins Schwitzen. Jede Minute werden sie heisser. Viele Kameras begrenzen die Videoaufnahme, um die Elektronik vor einem Hitzschlag zu schützen.

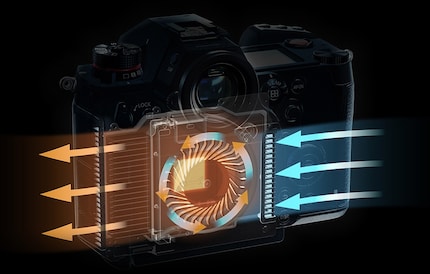

Kameras, die eine besonders hohe Videoqualität bieten, müssten eigentlich genauso gekühlt werden wie PCs. Doch mit der Wärmeabfuhr dieser Geräte steht es nicht zum besten. Als einzige mir bekannte Kamera hat die Panasonic Lumix S1H einen eingebauten Lüfter. Nicht zufällig ist sie auch ein absoluter Top-Shot im Videobereich.

Intensive Rechenvorgänge in der Kamera haben einen weiteren Nachteil: Der Akku ist innert kurzer Zeit leer. Es erstaunt daher wenig, dass die Kameras auf andere Methoden zurückgreifen, um in Echtzeit eine für Video passende Auflösung zu generieren. Diese Methoden erfordern weniger Rechenleistung, schaffen aber nicht die gleiche Bildqualität.

Die schlechteste, aber einfachste Methode, um auf die gewünschte Pixelzahl zu kommen, ist das eingangs erwähnte Cropping. Crop heisst auf Deutsch Zuschneiden. Beim berüchtigten 4K-Crop wird das Bild einfach auf die geforderte Pixelzahl beschränkt und der Rand drum herum weggeschnitten.

Das ist natürlich schlecht, weil du bei Fotos einen anderen Bildausschnitt hast als bei Videos. Weitwinkelaufnahmen im Video werden so unmöglich. Im Vlogging sind gerade die beliebt, weil sie viel von der Umgebung zeigen und eine grosse Tiefenschärfe aufweisen.

Deutlich besser ist Line Skipping, weil dadurch der Bildausschnitt erhalten bleibt. Bei dieser Methode werden ganze Zeilen oder Spalten auf dem Pixelraster ausgelassen. Dadurch ist die Datenmenge, die der Bildprozessor verarbeiten muss, von Anfang an geringer.

Doch die Bildqualität leidet darunter, dass nicht alle Bildinformationen genutzt werden, die der Sensor liefern würde. Werden zuerst alle Pixel gelesen und daraus ein UHD-Bild berechnet, wird das Bild eindeutig schärfer.

Beim Pixel Binning werden mehrere – üblicherweise vier – Pixel zu einem zusammengefasst. Logischerweise beträgt dann die Auflösung und die zu verarbeitende Datenmenge nur noch einen Viertel.

Weder Cropping noch Line Skipping noch Pixel Binning erreichen die Schärfe, die durch das Herunterrechnen der vollen Auflösung entsteht.

Die Hersteller geben nicht an, welches Verfahren sie für welche Auflösung verwenden. Aber wenn eine Kamera ein knackscharfes 4K-Bild liefert, Full HD dagegen matschig ist, lässt das darauf schliessen, dass bei 4K Oversampling verwendet wird und für Full HD entweder Pixel Binning oder Line Skipping.

Bei unserer Redaktionskamera Sony Alpha 6400 ist jedenfalls der Qualitätsunterschied zwischen 4K und Full HD frappant. Ich habe mal kurz den Innenhof des Bürogebäudes in 4K und FHD gefilmt, jeweils mit der höchsten verfügbaren Qualität. Im Bild unten siehst du links einen Ausschnitt mit FHD, rechts einen auf die gleiche Grösse heruntergerechneten 4K-Ausschnitt.

Wenn eine Kamera grundsätzlich fähig ist, die volle Pixelzahl live auf 4K herunterzurechnen, warum tut sie dasselbe nicht auch bei Full HD?

Solange 4K limitiert ist, etwa auf 30 Bilder pro Sekunde oder auf eine bestimmte Länge wie 10 oder 20 Minuten, braucht es andere Aufnahmeoptionen, die diese Limitierungen nicht aufweisen. Dazu dient Full HD. In der Regel lässt sich Full HD ohne Zeitlimit aufnehmen, mit Bildwiederholraten von bis zu 120 fps. Das geht nur mit den «billigen» Methoden.

Trotzdem verstehe ich nicht ganz, wieso es nicht auch bei Full HD eine Option für hohe Qualität gibt, welche Oversampling verwendet. Dass es technisch möglich ist, zeigen Kameras wie die Panasonic GH5: Sie berechnet normales Full HD aus der vollen Pixelzahl, erst bei hohen Framerates wie 120 fps greift sie auf eine weniger rechenintensive Methode zurück.

Das bedeutet, dass Full HD je nach Hersteller und Kamera eine sehr unterschiedliche Bildqualität liefert.

Angaben wie Full HD oder 4K sagen nur etwas über die nominelle Auflösung aus, nicht über die tatsächliche Schärfe, die eine Kamera hinbringt. Diese hängt davon ab, wie viele Informationen zur Berechnung des Videobildes genutzt werden. Oversampling nutzt alle Informationen des Sensors und ist die klar beste Methode, benötigt aber auch fette Rechenleistung und kann eine Kamera zum Kochen bringen.

Sehr irritierend finde ich, dass es offenbar Kameras gibt, die bei 4K Oversampling verwenden, bei Full HD jedoch eine «billigere» Methode. Dies ist in den Spezifikationen nicht zu sehen, in der resultierenden Qualität jedoch sehr wohl. Daher werde ich bei zukünftigen Tests das Bild von Full HD und 4K vergleichen.

Die Bildprozessoren der Kameras werden immer besser. Ich nehme an, dass künftige Generationen nicht mehr auf Tricks wie Line Skipping oder Cropping angewiesen sind, sondern auch hohe Framerates live aus dem gesamten Sensor berechnen können.

Durch Interesse an IT und Schreiben bin ich schon früh (2000) im Tech-Journalismus gelandet. Mich interessiert, wie man Technik benutzen kann, ohne selbst benutzt zu werden. Meine Freizeit ver(sch)wende ich am liebsten fürs Musikmachen, wo ich mässiges Talent mit übermässiger Begeisterung kompensiere.

Praktische Lösungen für alltägliche Fragen zu Technik, Haushaltstricks und vieles mehr.

Alle anzeigen